科学と文化のいまがわかる

デジタル

AIから個人情報が漏れる?

2018.03.14

あなたの好みの商品を選んでくれたり、専門の医師でも診断が難しい病気を見抜いてくれたり。人工知能=AIは私たちを取り巻くさまざまな場面ですでに活用が広がっている。その能力の“源”は、AIが学習する大量のデータだ。しかし、AIが学習した個人情報が流出するおそれがあるとしたら、あなたはどうするだろうか。

AIの能力の“源”は学習データ

日々、AIを取材しているとさまざまな企業や研究機関から新たなAIの開発に関する案内文が届く。

あなたの顔を認識して好みの商品を選んでくれるサービスから、工場の生産管理、自動運転、病気の診断の支援まで、活用の範囲はとどまることを知らない。

AIは、学習するデータに応じてさまざまな能力を身につけることができるのだ。もちろんその中には買い物の履歴や顔の画像など、私たちのプライバシーに関係する情報や企業が秘密にしたい情報もあり、通常、AIが学習したデータを第三者が取り出すことはできない。

サイバー攻撃でAIから情報漏えい?

ところが、AIのセキュリティーに一石を投じる実験結果を筑波大学人工知能科学センターの研究グループがまとめた。

「AIにサイバー攻撃を加えると、第三者が学習データを再現できてしまうかもしれない」。

どういうことなのか、実験の内容を取材した。

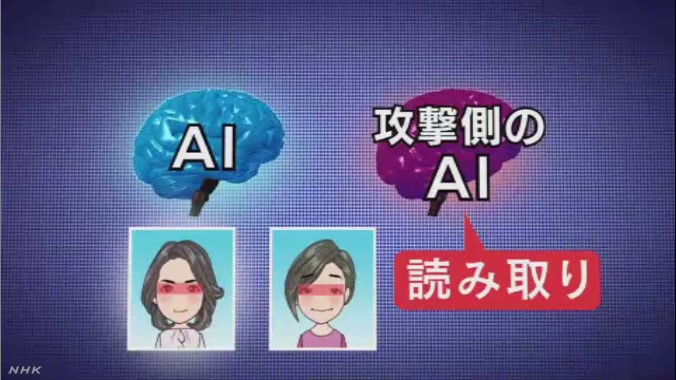

1.グループはまず、特定の人の顔を学習させ、その人の顔を見分けるAIを用意した。

2.次に、このAIを別のAIに攻撃させ、どんな顔のデータを学習したのかを探らせた。もちろん、攻撃側のAIは攻撃対象がどんな顔を認識しているのか、全く知らない。

ところが2日ほど実験を続けると、私たちが見ても「確かに似ている」とうなずける本物そっくりな“偽物”の顔を作り出し、攻撃対象のAIも本人と誤認識してしまったという。

カギを握る「GAN」

いったい、どうやって本物そっくりの顔を作り出すことができたのか。その鍵を握るのが、「Generative Adversarial Network」、「GAN」と呼ばれる仕組みだ。「敵対的生成ネットワーク」とも呼ばれている。

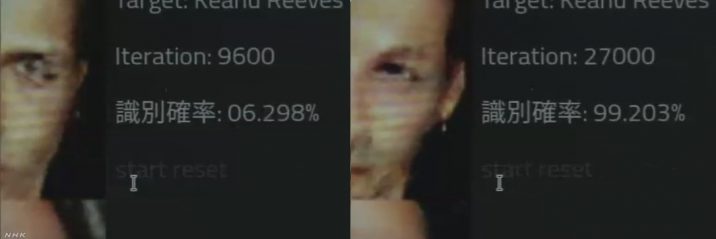

攻撃側のAIはまず、この仕組みを使い、いわば“あてずっぽう”に人の顔を描き、攻撃対象のAIに見せた。すると、攻撃対象のAIは本物かどうかを識別し、本物とどれくらい特徴が似ているかを満点を「1」として数値化した。この結果を踏まえ、攻撃側のAIは、数値が「1」に近づくよう考えながら偽物の顔を作り続けた。

その結果、最初は「0.1」などかなり低い値だったのが、2日ほどで「0.9」を超え、本物と“見間違える”レベルの顔を作り出したというのだ。

この実験は画像データに限っていることに加え、特定の人の顔を見分けるAIのプログラムを攻撃側が読み込めるという前提に立っているが、これは実際には難しく、直ちに悪用されるわけではない。

しかしグループでは、何者かがAIをハッキングすれば学習データを再現できるおそれがあるとしている。

学習データ再現 そのリスクは

将来、AIが学習した人の顔などの画像データが第三者に再現されてしまうと、そのリスクは単なるプライバシーの域にとどまらない。

今回の研究を行った筑波大学人工知能科学センターの佐久間淳教授は、「さらに高度な攻撃手法が開発された場合、所有者の顔を認識して機器のロックを解除する『顔認証』が突破され、第三者が本人になりすまして重要な機器を自由に操作できてしまうおそれがある」と指摘する。

こうしたリスクは現時点ではあくまで想像の段階だが、「これまでAIの開発では学習データが第三者に見られることは想定していなかった。データの中には企業の非公表の情報や個人の顔などもあり、対応が必要だ」と警鐘を鳴らしている。

海外でも研究が進むAIのリスク

AIの思わぬリスクにどう備えていくべきか。海外でもAIのぜい弱性についての研究が行われている。そのひとつが、物を誤って認識する問題だ。

アメリカ・マサチューセッツ工科大学の研究グループは、現状のAIが抱える画像認識の課題を突き、特殊な「亀」の模型を作ると、AIはこの模型を「銃」と誤って認識したという。

また、ワシントン大学は、交通標識の模型にあるステッカーを貼ると、「一時停止」の標識をAIが「速度規制」と誤って認識することを実験で示している。

AIは、その技術による恩恵など、「光」の部分に目が行きがちだが、国際的な会議でもAIのぜい弱性をめぐるワークショップが開かれるなど、まだ課題があるのが現状なのだ。

“技術進歩に向け課題克服を”

人工知能に詳しい東京大学の松尾豊特任准教授は、「これまでAIをどのように使っていくべきか、という議論は行われてきたが、AIそのもののぜい弱性についてはあまり議論されてこなかった。こうした課題は新しい技術が社会に浸透する度に必ず起きるもので、AIの導入に後ろ向きになるのではなく、さまざまな問題を一つ一つ解決しながらAIの技術を積極的に推し進めていく必要がある」と指摘している。

私たちの生活を大きく変えようとしている人工知能=AIの技術。社会への浸透が加速度的に進みつつある今、AIそのものが抱えるリスクにも目を向ける時期が来ているのかもしれない。